Big Data

16,1 Md$ : telle est l’ampleur du marché du big data pour l’année 2014. Une croissance 6 fois plus rapide que pour les autres secteurs de la technologie informatique. (IDC) L’idée de l’analyse prédictive, que souvent les gens appellent « big data » par amalgame, c’est de récupérer une grande quantité de données, d’extraire des motifs statistiques à l’intérieur, et de s’en servir pour essayer de prédire ce qui va se passer après.

Les big data, littéralement les « grosses données », ou mégadonnées, parfois appelées données massives, désignent des ensembles de données qui deviennent tellement volumineux qu’ils en deviennent difficiles à travailler avec des outils classiques de gestion de base de données ou de gestion de l’information. On parle aussi de datamasse en français par similitude avec la biomasse. Le Big Data s’accompagne du développement d’applications à visée analytique, qui traitent les données pour en tirer du sens. Ces analyses sont appelées Big Analytics ou «broyage de données». Elles portent sur des données quantitatives complexes avec des méthodes de calcul distribué. Les bases de données relationnelles classiques ne permettent pas de gérer les volumes de données du Big Data. De nouveaux modèles de représentation permettent de garantir les performances sur les volumétries en jeu. Ces technologies, dites de Business Analytics & Optimization (BAO) permettent de gérer des bases massivement parallèles.

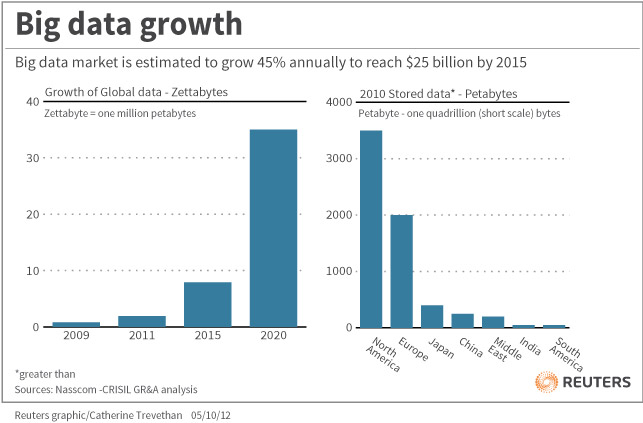

L’un des principaux enjeux de productivité du Big Data dans son évolution va porter sur la logistique de l’information, c’est-à-dire sur comment garantir que l’information pertinente arrive au bon endroit au bon moment. Il s’agit d’une approche micro-économique. Son efficacité dépendra ainsi de celle de la combinaison entre les approches micro- et macro-économique d’un problème. Selon une étude IDC, les données numériques créées dans le monde atteindraient 40 zettaoctets d’ici 2020. (Source)

Les méthodes actuelles de modélisation de données ainsi que les systèmes de gestion de base de données ont été conçus pour une utilisation à des fins commerciales de l’information. La fouille de données a des caractéristiques fondamentalement différentes et les technologies actuelles ne permettent pas de les exploiter. Dans le futur il faudra des modélisations de données et des langages de requêtes permettant :

- une représentation des données en accord avec les besoins de plusieurs disciplines scientifiques ;

- de décrire des aspects spécifiques à une discipline (modèles de métadonnées) ;

- de représenter la provenance des données ;

- de représenter des informations contextuelles sur la donnée ;

- de représenter et supporter l’incertitude ;

- de représenter la qualité de la donnée

Instituts d’études et sondage, l’effet big data

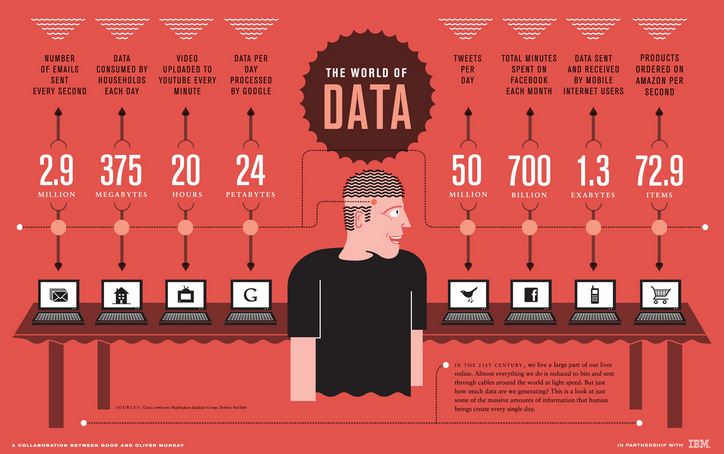

Signe des temps : le big data constitue l’un des 34 plans de “la nouvelle France industrielle”, telle qu’énoncée par le ministère du Redressement productif. On peut ainsi lire sur le site gouvernemental que “les enjeux sont considérables, d’abord sur un plan économique : on évalue à 8 % du PIB européen la création de valeur liée aux big data à l’horizon 2020”. Marketing, vie politique, milieu médical : le champ est immense. Mais le big data reconfigure-t-il également le B.a.-Ba des études d’opinion ? Il s’agit de l’une des peurs du secteur des instituts de sondage traditionnels : l’évolution technologique liée à la datamasse (le nom français du big data) va-t-elle les ringardiser, rendant leurs analyses caduques et dépassées par le règne du global ? Car avec les “grosses données”, le changement d’échelle est considérable, que ce soit en matière de capture, de partage, de stockage ou encore d’analyse. Le pari est donc d’envergure pour des instituts d’études, habitués à traiter l’information par échantillon, et qui doivent désormais composer avec des volumes gigantesques, puisés sur un Web multisupport, des réseaux sociaux en expansion et des informations en interne de plus en plus structurées. Avec 3,3 milliards de requêtes Google quotidiennes, 4,75 milliards de contenus Facebook partagés chaque jour et environ 255 millions d’inscrits sur Twitter, le gigantisme d’Internet a changé. Volume, variété, vélocité : nous utilisons de plus en plus des données que nous ne fabriquons pas, et ce en grandes quantités et dans une logique de flux. (Source)

TRANQUILIEN, un Open Data pour le réseaux Transilien SNCF

Pourquoi s’entasser dans le train de 7h55, qui est bondé, quand on a l’opportunité d’en prendre un autre, 10 minutes plus tard, dans lequel on est certain de trouver une place assise ? De même pourquoi investir l’avant du train qui est bondé alors que la dernière voiture est vide ? C’est le principe de Tranquilien : permettre à chacun, en fonction de ses contraintes et de son niveau de flexibilité horaire, de choisir le train et/ou la voiture la plus confortable en termes d’affluence. Vous pouvez y consulter le taux de remplissage des trains par voiture heure par heure, ligne par ligne et contribuer à la régulation du trafic en évaluant vous-même le confort global de vos déplacements. Tranquilien, c’est la petite appli qui participe à fluidifier les trajets des 3 millions de voyageurs qui se croisent chaque jour sur les lignes du réseau Transilien… (OpenData Tranquilien)

De plus, SNCF propose un Baromètre de la régularité des trains. Réalisé par WeDoData, ce baromètre permet de consulter chaque mois l’évolution de la régularité pour TGV, TER, Intercités et Transilien. Ces données de régularité sont également accessibles en Open Data et sont librement réutilisables. Objectif pour la suite : descendre en granularité pour proposer une information à J+1. (Source)

À quoi ressemblera la ville de 2030 si les sciences prédictives se diffusent et se généralisent ?

Si on veut véritablement améliorer la qualité de vie des citadins, il ne faut pas seulement s’intéresser aux infrastructures mais aussi aux gens, remettre le citoyen au cœur de la réflexion sur la data et la manière dont on structure les villes. En faisant ça, il est possible de créer des villes qui changent et s’adaptent à la façon de vivre des individus. La ville qu’on imagine demain, c’est un espace tellement interconnecté qu’il n’y a plus vraiment de différence entre le monde digital et le monde physique, où notre environnement s’adapte à ce qu’on cherche à faire. La ville qu’on imagine demain, c’est un espace tellement interconnecté qu’il n’y a plus vraiment de différence entre le monde digital et le monde physique, où notre environnement s’adapte à ce qu’on cherche à faire. Les rails ou les immeubles ne bougent pas, ils sont fixes. Mais l’utilisation qu’on a d’un immeuble peut changer, les horaires des trains peuvent être dynamiques. On peut réaliser tout cela grâce à la data. (Entretien avec Rand Hindi par Rue89)

L’analyse prédictive

L’analyse (ou logique) prédictive englobe une variété de techniques issues des statistiques, d’extraction de données et de la théorie des jeux qui analysent des faits présents et passés pour faire des hypothèses prédictives sur des événements futurs. Dans le monde des affaires, des modèles prédictifs exploitent des schémas découverts à l’intérieur des ensembles de données historiques et transactionnels pour identifier les risques et les opportunités. L’analyse prédictive, considérée comme un type d’exploration de données, est un domaine de l’analyse statistique qui extrait l’information à partir des données pour prédire les tendances futures et les motifs de comportement. Le cœur de l’analyse prédictive se fonde sur la capture des relations entre les variables explicatives et les variables expliquées, ou prédites, issues des occurrences passées, et l’exploitation de ces relations pour prédire les résultats futurs. (Source)

L’analyse prédictive permet d’augmenter le taux de conversion en ligne de 30%

L’analyse prédictive est devenue cruciale pour les services marketing et il n’est pas difficile d’en comprendre les raisons. Que ce soit au travers des caisses enregistreuses des magasins, des cartes de fidélité, ou par le biais des sites Web, des smartphones et des tablettes, les commerçants accumulent de plus en plus de données client à chaque point de vente et via tous les canaux. Tout ceci vient alimenter le Big Data, dans lequel l’historique et les transactions du client peuvent être analysées, décortiquées tout au long de sa vie, et restituées dans des tableaux de bord.

Suivre le comportement des clients est sans aucun doute très utile. Cependant, les réels bénéfices apparaissent quand il est possible d’analyser toutes ces données et d’utiliser les informations pour prédire ce que le client va faire par la suite. Par exemple, si le comportement d’un client d’une compagnie aérienne laisse apparaître que prochainement, il est susceptible de devenir un voyageur régulier, la compagnie en question peut adapter ses messages marketing en se fondant sur cette éventualité . De même, les distributeurs peuvent utiliser l’analyse prédictive pour personnaliser le contenu des pages destinées à leurs clients. (Source)

La modélisation prédictive : tout sauf de la magie !

La démarche consiste à prédire l’apparition d’un évènement (variable à expliquer) par rapport à des prédicteurs (appelés variables explicatives). Les algorithmes utilisés sont nombreux et dépendent des distributions des données : lesquels couvrent les modèles paramétriques (régression linéaire, analyse discriminante…) et les modèles non-paramétriques (arbres de décision, réseaux de neurones, plus proches voisins…).

La question suivante est de retenir le meilleur modèle dans la situation donnée. Toutes ces méthodes se manipulent et se comparent de façon intuitive avec une souris. Les graphiques et les statistiques d’aide à la décision sont d’ailleurs produits automatiquement. La meilleure méthode est également proposée par défaut : l’expert métier se concentre alors sur la traduction opérationnelle de ses travaux.

L’apport de ce type d’approche fait rêver beaucoup de décideurs : pouvoir comprendre et anticiper les comportements (d’un client, d’une entreprise, d’un matériel…) avant qu’ils ne surviennent, afin de mettre en place des pistes d’amélioration ou des actions correctrices, peut sembler directement sorti des cerveaux les plus farfelus amateurs de science-fiction. Pourtant, ces méthodes sont parfois anciennes (plusieurs dizaines d’années) et reposent en toute simplicité sur l’analyse des données réelles à disposition. (Source)

href="http://rue89.nouvelobs.com/2014/08/24/algorithmes-devins-les-smartphones-bientot-deuxiemes-cerveaux-254326?utm_source=outbrain&utm_medium=widget&utm_campaign=obclick&obref=obinsource" data-color-override="false" data-hover-color-override="false" data-hover-text-color-override="#fff">Button Text href="http://opendata.transilien.com/apps/tranquilien/" data-color-override="false" data-hover-color-override="false" data-hover-text-color-override="#fff">Button Text href="https://data.sncf.com" data-color-override="false" data-hover-color-override="false" data-hover-text-color-override="#fff">Button Text href="http://fr.wikipedia.org/wiki/Données_ouvertes" data-color-override="false" data-hover-color-override="false" data-hover-text-color-override="#fff">Button Text href="http://fr.wikipedia.org/wiki/Big_data" data-color-override="false" data-hover-color-override="false" data-hover-text-color-override="#fff">Button Text href="https://www.data.gouv.fr/fr/" data-color-override="false" data-hover-color-override="false" data-hover-text-color-override="#fff">Button Text href="https://datascience.net/fr/home/" data-color-override="false" data-hover-color-override="false" data-hover-text-color-override="#fff">Button Text href="http://opendata.paris.fr/page/home/" data-color-override="false" data-hover-color-override="false" data-hover-text-color-override="#fff">Button Text href="http://www.lemondeinformatique.fr/actualites/lire-analyse-predictive-le-data-scientist-doit-travailler-en-equipe-59360.html" data-color-override="false" data-hover-color-override="false" data-hover-text-color-override="#fff">Button Text href="http://www.lemondeinformatique.fr/big-data-139.html" data-color-override="false" data-hover-color-override="false" data-hover-text-color-override="#fff">Button Text href="http://www.lesechos.fr/idees-debats/cercle/cercle-92023-lanalyse-predictive-permet-daugmenter-le-taux-de-conversion-en-ligne-de-30-1003060.php" data-color-override="false" data-hover-color-override="false" data-hover-text-color-override="#fff">Button Text href="http://www.lenouveleconomiste.fr/lesdossiers/instituts-detudes-et-sondage-leffet-big-data-24104/" data-color-override="false" data-hover-color-override="false" data-hover-text-color-override="#fff">Button Text href="http://www.statistique-2013.fr/03-modelisation-predictive.shtml" data-color-override="false" data-hover-color-override="false" data-hover-text-color-override="#fff">Button Text href="http://blog.ontrack.fr/big-data-marketing/" data-color-override="false" data-hover-color-override="false" data-hover-text-color-override="#fff">Button Text

Imaginez un monde où votre téléphone communiquerait en permanence avec la compagnie centrale de téléphone pour décider quels membres de votre famille vous avez le droit d’appeler et réorganiser leurs phrases dans l’ordre qui leur semblerait le meilleur (pour vous garder « engagé » et pour que vous restiez plus longtemps au téléphone), tout en entrecoupant vos appels de publicités. C’est à ça que ressemblent la plupart de nos plateformes aujourd’hui. Nous ne possédons plus vraiment nos intermédiaires. Au contraire, ceux-ci obéissent à une série d’algorithmes, qui ne nous expliquent rien et ne nous rendent pas de comptes. 2015 :… Lire la suite »

Avant il y avait des classements par groupes socioprofessionnels et des produits rangés selon des thématiques. Aujourd’hui, pour un e-commerçant qui a 20 millions de clients et 500 000 produits au catalogue, la complexité est telle que prétendre tout classer est absurde. Les données sont très hétérogènes et trop volumineuses. Elles dépassent l’intelligence humaine. Seuls des algorithmes avancés peuvent saisir les nuances et être “intelligents”. Pendant dix ans, j’ai fait de la recherche en mathématiques pures sans me soucier des applications. J’ai découvert il y a cinq ans que certains algorithmes s’appliquaient très bien à la prédiction des comportements de consommation. Et… Lire la suite »